To Know but Not Understand:

David Weinberger

on Science and Big Data

Link to the original text:

“To Know but Not Understand: David Weinberger on Science and Big Data” (The Atlantic)

David Weinberger

I would like to thank David Weinberger and The Atlantic for allowing me to translate and publish such an interesting article. Dr. Weinberger was very kind in his response upon contacting him, expressed his gratitude for my interest and gave his permission immediately.

Conocer pero no comprender:

David Weinberger sobre la ciencia y los macrodatos

En un fragmento editado de su nuevo libro, Too Big to Know, David Weinberger explica cómo a pesar de que las enormes cantidades de datos necesarios para tratar fenómenos complejos exceden la capacidad de comprensión de cualquier cerebro individual la ciencia de redes sigue adelante.

Thomas Jefferson y George Washington anotaban a diario sus observaciones del tiempo, pero no lo hacían a cada hora o a cada minuto. No solo tenían otras cosas que hacer, sino que tales datos no parecían ser útiles. Incluso después de que la invención del telégrafo permitiera la centralización de los datos sobre el tiempo, los 150 voluntarios que recibían instrumental de meteorología del Instituto Smithsoniano en 1849 solo presentaban sus informes una vez al día. En la actualidad, existe un flujo continuo de datos meteorológicos que es literalmente inconmensurable, gracias a satélites que rondan la Tierra, boyas que se bambolean en el océano y sensores con Wi-Fi en las selvas. Medimos las temperaturas, las precipitaciones, la velocidad de los vientos, los niveles de CO2 y la presión que ejerce el viento solar. Todos estos y muchos, muchos más datos comenzaron a ser útiles de registrar cuando se volvió posible hacerlo, cuando se logró procesarlos con computadoras y cuando se logró conectar los flujos y los procesadores de datos en una red.

¿Cómo podremos comprender alguna vez temas científicos que son demasiado grandes para conocerlos? En pocas palabras: al transformar qué significa conocer algo científicamente.

No sería la primera vez. Por ejemplo, cuando Sir Francis Bacon dijo que el conocimiento del mundo debía basarse en hechos sobre este, verificados de manera cuidadosa, no solo nos estaba proporcionando un método nuevo para obtener un conocimiento a la antigua. Estaba redefiniendo el conocimiento como teorías que se basan en hechos. La era de la Red trae consigo una redefinición de la misma magnitud. El conocimiento científico adquiere propiedades de su nuevo medio, se asemeja a la red en la que vive.

En este fragmento de mi nuevo libro, Too Big To Know, veremos una propiedad esencial del conocimiento como red: la enormidad.

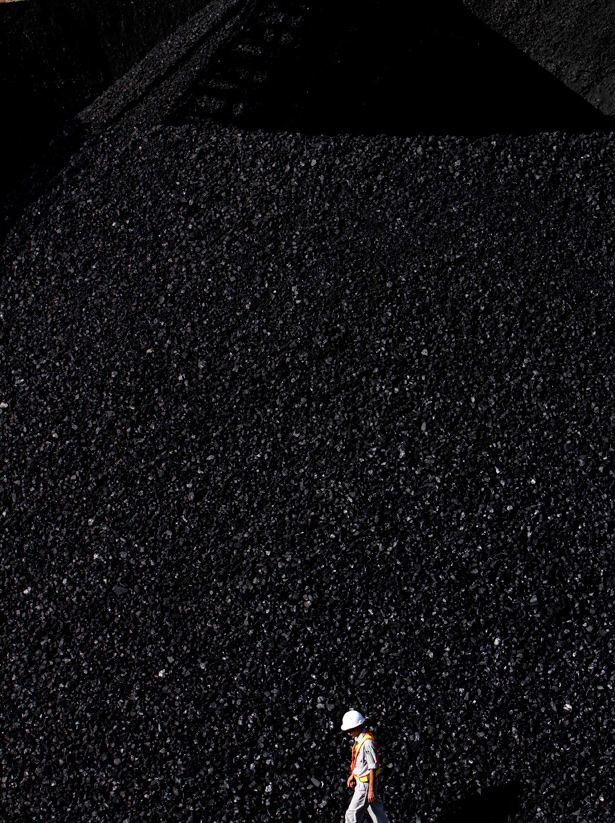

En una carta que se publicó en la prestigiosa revista Science en 1963 y que hoy es famosa, Bernard K. Forscher, de la Clínica Mayo se quejaba de que los científicos generaban demasiados datos. Titulada Chaos in the Brickyard (Caos en el ladrillar), la carta advertía que la nueva generación de científicos estaba demasiado ocupada en la generación de ladrillos (datos), sin dar importancia a cómo encajaban entre sí. La producción de ladrillos, temía Forscher, se había vuelto un fin en sí mismo. “Y así ocurrió que la tierra se inundó de ladrillos. […] Se volvió difícil hallar los ladrillos adecuados para una tarea porque había que buscarlos entre una gran cantidad de ellos. […] Se volvió difícil completar una edificación útil, porque, tan pronto como se podía discernir el fundamento, este quedaba cubierto bajo una avalancha de ladrillos aleatorios.”

Si la ciencia parecía un ladrillar caótico en 1963, el doctor Forscher se hubiera sentado a lamentarse si hubiera visto el Global Biodiversity Information Facility [Servicio informático de biodiversidad global] en GBIF.org. En los últimos años, el GBIF recopiló miles de colecciones de datos-ladrillos sobre la distribución de la vida en nuestro planeta, desde la colección de bacterias en el Instituto Nacional de Salud Pública en Polonia hasta el censo de focas de Weddell en las colinas Vestfold de la Antártida. GBIF.org está diseñado para ser precisamente el tipo de ladrillar que el doctor Forscher detestaba (información presentada sin hipótesis, teoría o estructura), pero muchísimo más grande, ya que el buen doctor no pudo haber previsto las redes de ladrillares.

De hecho, las redes de ladrillares basados en datos son una industria en crecimiento. Por ejemplo, en ProteomeCommons.Org, se puede hallar información sobre las proteínas específicas de diversos organismos. Un proyecto independiente de un estudiante de posgrado, Proteome Commons ofrece casi 13 millones de archivos de datos, un total de 12,6 terabytes de información. Los datos provienen de científicos de todo el mundo y están a disposición de todos, de manera gratuita. La Encuesta digital de los cielos Sloan (bajo el modesto epígrafe “El mapa del universo”) recopila y publica mapas de los cielos obtenidos de 25 instituciones en todo el mundo. Su encuesta inicial, terminada en 2008 tras ocho años de trabajo, publicó información sobre unos 230 millones de objetos celestes, entre ellos 930.000 galaxias; cada galaxia contiene millones de estrellas, por lo que este ladrillar podría alcanzar un tamaño que nos diera problemas para nombrar el número. El más famoso de los nuevos ladrillares de datos, el Proyecto Genoma Humano, completó en 2001 la cartografía de toda la secuencia genética de la especie humana; fue superado en términos de cantidad por la Base de datos colaborativa internacional de la secuencia de nucleótidos (INSDC), que para mayo de 2009 había recopilado 250 mil millones de datos genéticos.

Existen tres razones básicas por las que los datos científicos crecieron al punto de que la metáfora del ladrillar parece ahora del siglo XIX. En primer lugar, la economía de la eliminación cambió. Solíamos desechar la mayoría de las fotografías que tomábamos con nuestras pobres cámaras de película antiguas porque, a pesar de que eran mucho más costosas de crear que las imágenes digitales de hoy, los álbumes de fotografías eran onerosos, ocupaban espacio y precisaban que dedicáramos un tiempo considerable a decidir qué fotografías iban a quedar. En la actualidad, suele ser menos costoso almacenar todo en nuestro disco duro (o en alguna página web) que hacer una selección.

Segundo, la economía de la divulgación cambió. La Biblioteca del Congreso tiene decenas de millones de objetos almacenados porque la física dificulta que se puedan exhibir y preservar, mucho menos compartir, objetos físicos. La Internet hace que sea mucho más sencillo compartir lo que está en nuestros sótanos digitales. Cuando los conjuntos de datos son tan grandes que se vuelven inmanejables incluso para Internet, los innovadores se ven motivados a inventar nuevas formas de compartir. Por ejemplo, Tranche, el sistema detrás de ProteomeCommons, creó su propio protocolo técnico para compartir terabytes de datos en la Red, de manera que no es una sola fuente la responsable de producir toda la información; el mismo proceso de compartir se comparte en toda la red. El nuevo formato de datos vinculados facilita más que nunca la segmentación de datos en trozos pequeños que se pueden hallar y reutilizar. La capacidad de acceder y compartir a través de la Red acrecienta aún más la nueva economía de la eliminación; los datos que de otra forma no hubiera valido la pena almacenar cobran un nuevo valor potencial porque la gente puede hallarlos y compartirlos.

Tercero, las computadoras se han vuelto exponencialmente más capaces. John Wilbanks, vicepresidente de Ciencia en Creative Commons (antes llamado Science Commons), destaca que “cartografiar un gen solía llevar un año. Hoy se pueden cartografiar treinta mil por día en una computadora de escritorio. Con una máquina de US$2.000, una micromatriz, ahora se puede observar cómo reacciona el genoma humano a lo largo del tiempo”. Pocos días después de que se diagnosticara al primer humano con el virus H1N1 de la gripe porcina, ya se había analizado y compartido en un depósito global la secuencia H1 de 1.699 bases. La capacidad de procesamiento disponible incluso en computadoras de escritorio agrega aún más valor potencial a los datos almacenados y compartidos.

El ladrillar creció hasta alcanzar proporciones galácticas, pero todavía hay más malas noticias para el doctor Forscher. No solo ocurre que existen demasiados ladrillares y estructuras teóricas insuficientes. Más bien, la creación de galaxias de datos nos llevó a una ciencia que a veces es tan rica y compleja que no se puede reducir en teorías. Como la ciencia se volvió demasiado grande para conocerla, adoptamos ideas diferentes sobre el significado mismo del conocimiento.

Por ejemplo, el sistema biológico de un organismo tiene una complejidad inimaginable. Hasta el elemento más simple de la vida, una célula, es en sí un sistema. Una ciencia nueva, denominada biología de sistemas, estudia las maneras en las que los estímulos externos envían señales a través de la membrana celular. Algunos estímulos producen respuestas relativamente simples, pero otros producen cadenas de reacciones. Estas señales no se pueden comprender de manera aislada. La imagen total de las interacciones incluso en una sola célula es más de lo que un ser humano que se compone de dichas células puede comprender. En 2002, cuando Hiroaki Kitano escribió un artículo de portada sobre biología de sistemas para la revista Science (un reconocimiento formal de la creciente importancia de este campo nuevo), dijo: “La principal razón por la que cobra interés renovado en estos días es que el progreso en biología molecular (…) nos permite recabar conjuntos de datos comprensivos sobre el funcionamiento de los sistemas y obtener información sobre las moléculas subyacentes”. Por supuesto, la única razón por la que somos capaces de recabar conjuntos de datos comprensivos es que las computadoras se volvieron muy grandes y capaces. La biología de sistemas era sencillamente imposible en la era de los libros.

El resultado de haber accedido a todos estos datos es una ciencia nueva que es capaz de estudiar no solo “las características de partes aisladas de una célula u organismo” (cito a Kitano), sino también las propiedades que no ocurren en el nivel de las partes. Por ejemplo, una de las características más impresionantes de los organismos vivos es que somos robustos: nuestros cuerpos se recuperan una y otra vez hasta que, por supuesto, ya no lo hacen. La robustez es una propiedad de un sistema, no de sus elementos individuales, que pueden no ser robustos y, como las hormigas que protegen a la reina, pueden “sacrificarse” para que el sistema total pueda sobrevivir. De hecho, la vida misma es una propiedad de un sistema.

El problema, o el cambio al menos, es que los humanos no podemos comprender sistemas ni siquiera de la complejidad de una célula simple. No es que estemos esperando alguna teoría elegante que acomode todos los detalles en su lugar. La teoría ya está establecida: los sistemas celulares consisten en un conjunto de interacciones detalladas que se pueden pensar en términos de señales y respuestas. Pero esas interacciones sobrepasan en cantidad y complejidad la capacidad de los cerebros humanos para comprenderlas. La ciencia de tales sistemas requiere de computadoras para almacenar todos los detalles y observar cómo interactúan. Los biólogos de sistemas construyen modelos informáticos que replican en un software lo que ocurre cuando interactúan millones de piezas. Es algo así como pronosticar el tiempo, pero depende mucho más de eventos particulares y menos de principios generales.

Los modelos de tal complejidad (ya sean sobre biología celular, meteorológicos, económicos, incluso de tráfico vehicular) suelen ser insuficientes, porque el mundo es más complejo de lo que pueden capturar. Sin embargo, a veces pueden predecir con exactitud cómo se comportarán los sistemas. En su mayor complejidad, estas son ciencias de emergencia y complejidad, que estudian propiedades de sistemas que no se pueden observar solo al analizar las partes ni se pueden predecir sin observar qué es lo que ocurre.

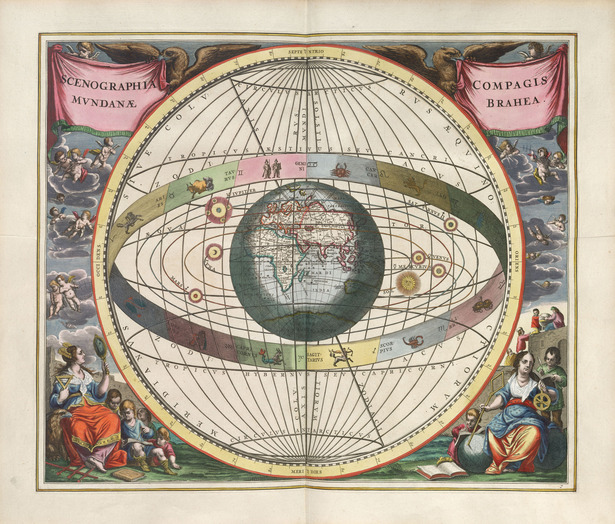

Esto representa todo un giro en el camino de la ciencia. Para Sir Francis Bacon hace 400 años, para Darwin hace 150 años, para Bernard Forscher hace 50 años, el objetivo de la ciencia era construir teorías que explicaran y se basaran en hechos. Los hechos tratan sobre cosas particulares, mientras que el conocimiento (tal como se lo concebía) debe ser universal. Todo avance en el conocimiento de los universales nos acercaba más a cumplir el destino que nuestro Creador nos había dispuesto.

Esta estrategia también tenía un costado práctico, por supuesto. Existen muchos menos universales que particulares y por lo general se pueden deducir los particulares si se conocen los universales: si se conocen los teoremas universales que explican las órbitas de los planetas, es posible averiguar en qué parte del cielo estará Marte durante determinado día de la Tierra. Apuntar a los universales es una táctica simplificadora dentro de nuestra estrategia tradicional más amplia para tratar con un mundo que es demasiado grande para conocer, al reducir el conocimiento a lo que nuestros cerebros y nuestra tecnología nos permiten abordar.

Por lo tanto, observábamos tablas de números hasta que descubríamos sus patrones simples. Johannes Kepler estudió meticulosamente las cartas estelares que había diseñado su jefe, Tycho Brahe, hasta que descubrió en 1605 que si los planetas orbitan el Sol en elipses y no en círculos perfectos todo tiene un sentido sencillo. Trescientos cincuenta años después, James Watson y Francis Crick observaron radiografías de ADN hasta que descubrieron que si las moléculas eran una doble hélice, los datos sobre las distancias entre sus átomos tenían un sentido sencillo. Con estos descubrimientos, los datos pasaron de ser confusamente aleatorios a revelar un orden que nos es comprensible: ¡Ah, las órbitas son elípticas! ¡Ah, la molécula es una doble hélice!

Con la nueva ciencia basada en bases de datos, suele ocurrir que no existe ningún momento en el que lo complejo se vuelve tan simple como para poder comprenderlo. El modelo no se reduce a una ecuación que nos permita hacer a un lado el modelo. Es necesario hacer simulaciones para ver qué ocurre. Por ejemplo, un modelo por computadora del movimiento de personas que huyen de una amenaza en un espacio delimitado (están en pánico) muestra que colocar una columna de casi un metro frente a una puerta de salida, ubicada levemente a un lado, en realidad aumenta el flujo de personas que salen por la puerta. ¿Por qué? Puede existir una teoría o quizás sea solo una propiedad emergente. Podemos subir por la escalera de la complejidad desde los juegos de socialización hasta los humanos que solo pretenden salir de un edificio en llamas o los fenómenos con muchas más personas con motivaciones mucho más diversas y cambiantes, como los mercados. Podemos modelar todas estas cosas y quizás saber cómo funcionan sin comprenderlas. Son tan complejas que solo nuestros cerebros artificiales pueden tratar la cantidad de datos y el número de interacciones que ocurren.

Lo mismo se da con los modelos de las interacciones puramente físicas, ya sean de células, de patrones meteorológicos o de motas de polvo. Por ejemplo, Hod Lipson y Michael Schmidt, de la universidad de Cornell, diseñaron el programa informático Eureqa para hallar ecuaciones que puedan encontrar un sentido a grandes cantidades de datos que han dejado estupefactos a los humanos, incluyendo la comunicación celular y el efecto de la cocaína en los glóbulos blancos. Eureqa busca ecuaciones posibles que puedan explicar la relación de algunos datos relacionados y luego modifica y evalúa esas ecuaciones para determinar si los resultados se ajustan con mayor precisión a los datos. Luego, repite este proceso hasta obtener una ecuación que funcione.

El doctor Gurol Suel, del Southwestern Medical Center de la Universidad de Texas, utilizó Eureqa para intentar descubrir qué ocasiona las fluctuaciones entre todos los miles de elementos diferentes en una sola bacteria. Luego de tratar con el ladrillar de datos que Suel le había dado, Eureqa mostró dos ecuaciones que expresaban constantes dentro de la célula. Suel obtuvo su respuesta. Pero él no la comprende ni piensa que alguien pueda hacerlo. Es como si Einstein hubiera soñado con e = mc2 y hubiera confirmado que funcionaba, pero nadie pudiera descubrir qué significa c.

Nadie cree que tener una respuesta que los humanos no podamos comprender sea satisfactorio. Queremos Eureka, no solo Eureqa. En algunos casos, sin dudas lograremos comprender las ecuaciones oraculares que produce nuestro software. Por otra parte, uno de los científicos que utiliza Eureqa, el biofísico John Wikswo, le dijo a un periodista de Wired: “La biología es de una complejidad incomprensible, demasiado complicada para que las personas comprendan las soluciones a su complejidad. La solución a este problema es el proyecto Eureqa”. Es posible que la complejidad del mundo sencillamente supere la capacidad de nuestros cerebros para entenderla.

El conocimiento basado en modelos cuenta con muchas dificultades bien documentadas, en especial cuando intentamos predecir eventos del mundo real sujetos a los caprichos de la historia; un modelo de la ecología del cretácico no hubiera incluido la llegada de un asteroide gigante entre sus datos y nadie espera un cisne negro. De todas maneras, los modelos pueden tener la capacidad predictiva que exigen las hipótesis científicas. Tenemos una nueva forma de conocer.

Este nuevo conocimiento requiere no solo de computadoras gigantes sino también de una red que las conecte, para alimentarlas y para hacer que su trabajo sea accesible. Existe a nivel de la red, no en las mentes de los seres humanos individuales.

DAVID WEINBERGER es jefe de investigación en el Berkman Center de Harvard. Es autor de varios libros, entre ellos, el más reciente, Too Big to Know.

© David Weinberger 2012, as originally published in The Atlantic.

Leave A Comment